Фейки и AI

Картинка, сгенерированная за пять минут в шутку, в эти дни может реально стоить жизни и здоровья людей. Как не поддаться лжи и пропаганде.

Во время войны опасность интернет-фейков еще выше, чем обычно. Картинка, сгенерированная за пять минут в шутку, в эти дни может реально стоить жизни и здоровья людей. Наши друзья из Adversal AI Research подготовили для своего блога подробную инструкцию, как определять фейки, сгенерированные с использованием AI-технологий и не поддаться лжи и пропаганде.

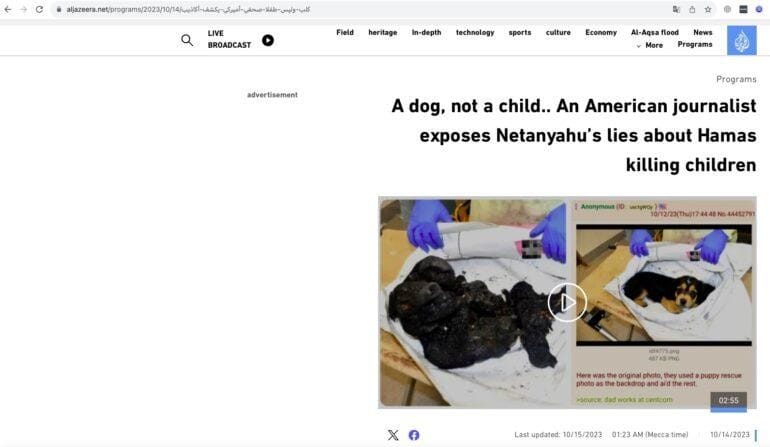

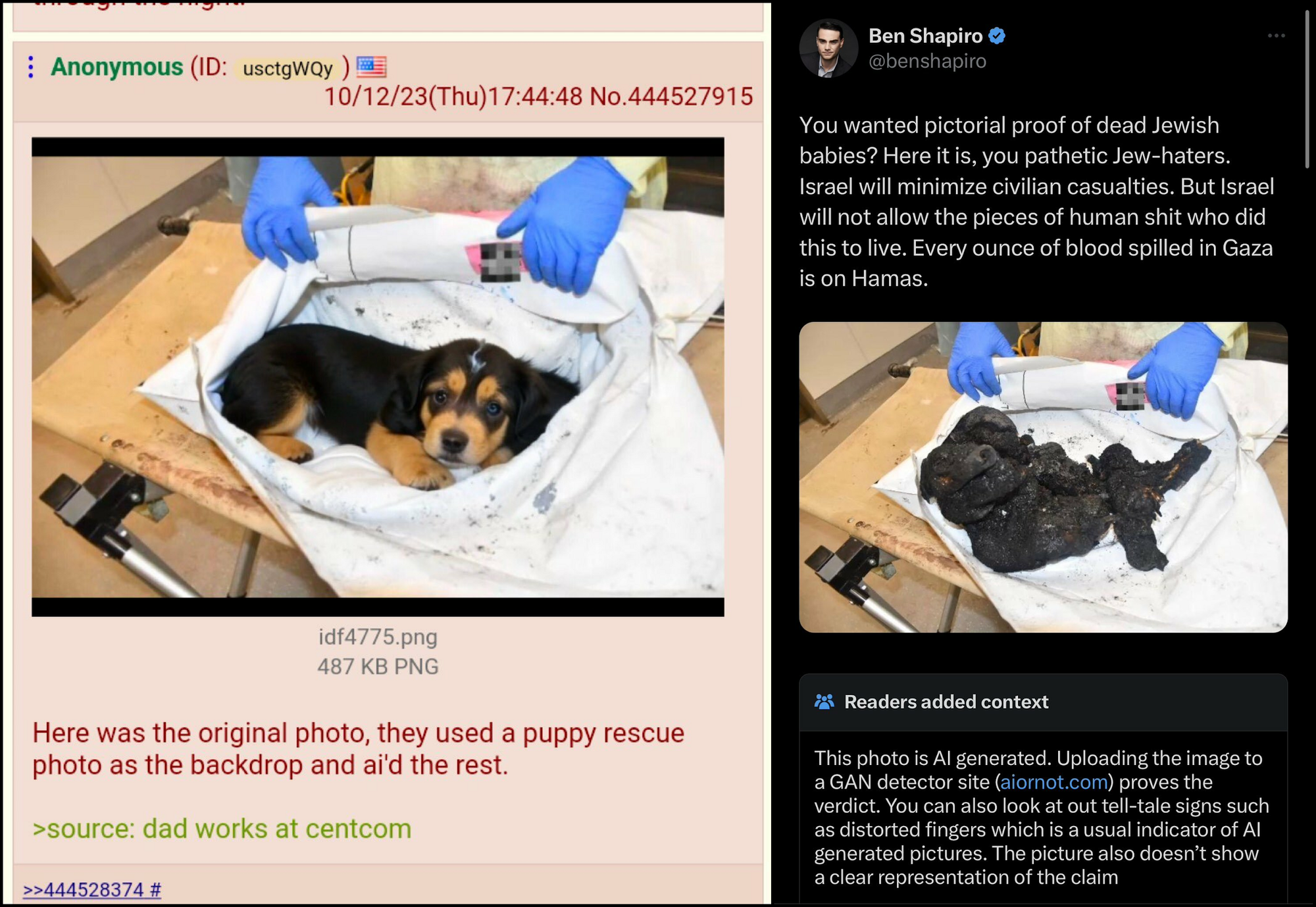

На прошлой неделе, после того, как ЦАХАЛ выпустил изображения жертв нападения 7 октября, ютубер и политический обозреватель Джексон Хинкель (Jackson Hinkle) написал консервативному журналисту Бену Шапиро (Ben Shapiro), что фотографии фальшивые: что-де он проверил фотографии обгоревшего трупа ребенка, которой поделился Шапиро, при помощи Optic AI or Not, и программа пометила изображения как фальшивые. Некоторые твиттерские даже нашли возможный источник этой подделки — картинку со щенком!

Весь тот тред был похож скорее на дурацкую несмешную шутку, и, строго говоря, в эту историю с фото щенка мало кто из комментаторов поверил, но, тем не менее, мы в Adversal AI Research решили проанализировать изображения из твитов Хинкеля и Шапиро, чтобы доказать, что фотографии сожженных детей настоящие. Результатами нашего небольшого расследования мы в частном порядке поделились с обоими блогерами. Внезапно, позже Альджазира и ряд других СМИ стали писать, на основе треда с щенячим фото, что фотографии сожженных еврейских детей — это фейк. Миллионы людей видели перепосты этой лжи и стали жертвами пропаганды.

Вообще говоря, это, конечно, не первый раз, когда достоверность новостей Альджазиры вызывает сомнения, но, как нам кажется, в этом конкретном случае особенно важно разобраться, где же правда.

Сегодня опасность подобных фейков особенно высока и мы надеемся, что этот материал может послужить доступным гайдом, чтобы помочь вам самим определять фейки — ведь их число, к большому нашему сожалению, будет только расти.

Команда Adversal AI Research давно и плотно занимается фейками, созданными при помощи искусственного интеллекта, а первую подробную статью об этом наш основатель написал для Forbes ещё в 2020 году.

1. Картинка из исходного твита

Урок первый. Смотрите внимательнее

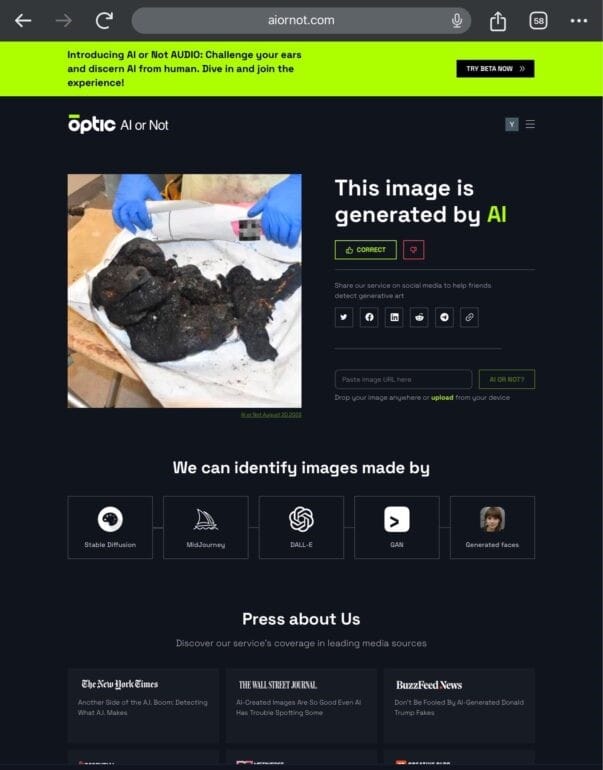

Давайте посмотрим на исходный твит Джейсона Хинкеля, в котором тот утверждает, будто некий инструмент для определения фейков показал, что фото создано при помощи AI.

В твите два скриншота. На втором — страница сервиса для определения фейков aiornot.com. Под фотографией на скриншоте надпись: «AI or not August 20 2023».

Подозрительная дата, за пару месяцев до событий, да и в текущем интерфейсе сервиса в принципе нет подобной строки. Похоже на то, что кто-то просто вставил изображение в старый скриншот! В принципе, на этом можно было бы наше «расследование» и закончить. Но давайте копнем поглубже.

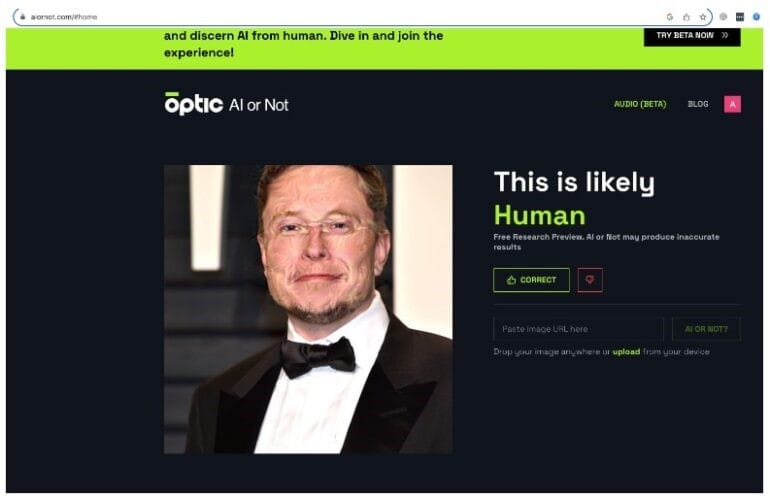

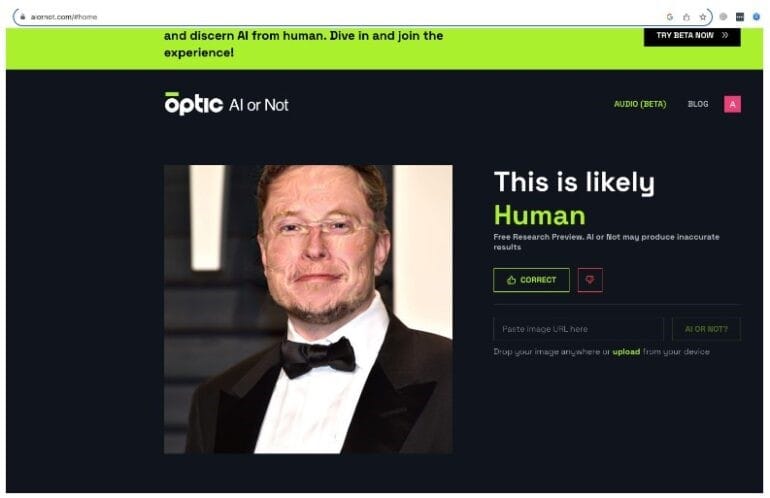

2. Что на самом деле показывает Optic AI or Not

Урок второй. Постарайтесь воспроизвести результат

Если исходное изображение протестировать при помощи Optic AI or Not, сервис сообщает, что оно, скорее всего, не является сгенерированным AI. Конечно, мы не можем знать, менялось ли что-то в алгоритме проверки за прошедшее время, но прямо сейчас определитель фейков, на который ссылались в качестве подтверждения фейковости изображения, говорит нам, что фотография подлинная.

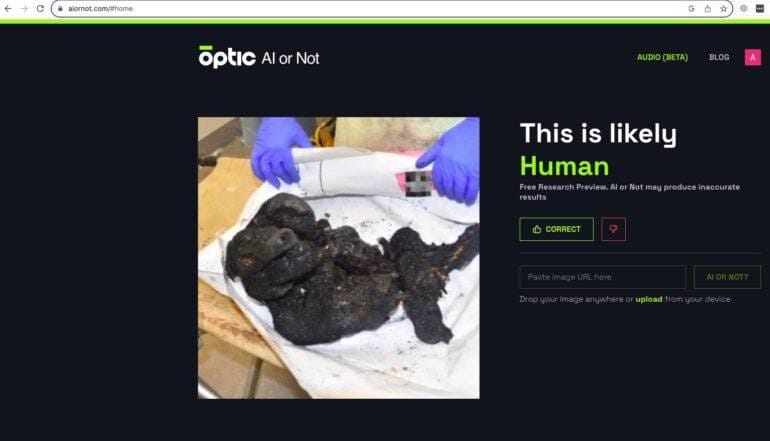

3. Качество анализа Optic AI or Not

Урок третий. Пробуйте разные варианты

Честно сказать, мы вообще не рекомендовали бы использовать этот сервис как доказательство чего-либо — процент ошибок, которые он выдает, слишком высок. В наших тестах он не смог определить ряд изображений, которые были созданы с помощью AI. Впрочем, ошибки были и в обратную сторону. На скриншоте ниже, например, он пометил изображение «likely human», то есть как созданное, скорее всего, без использования AI, в то время как оно очевидно было обработано при помощи AI-алгоритма.

А вот другой пример: мы предложили для анализа фото, сгенерированное в FaceApp. Как видите, инструмент от Optic предполагает, что это — реальное фото человека.

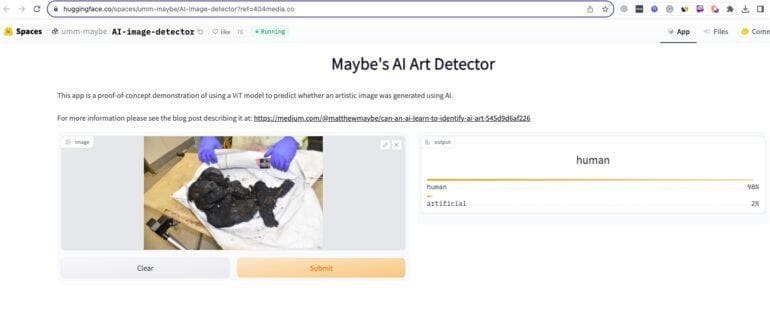

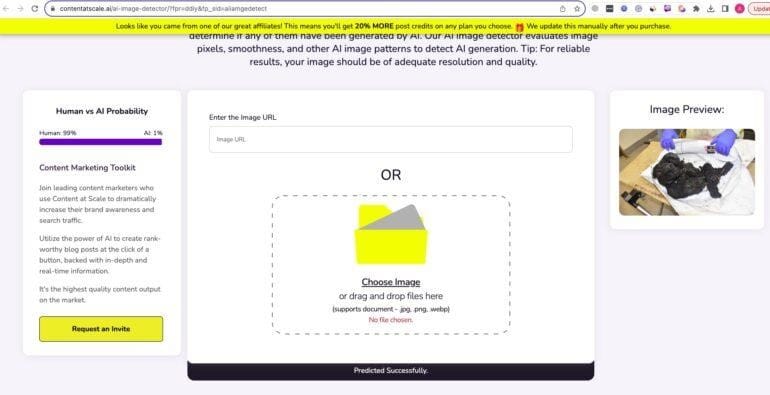

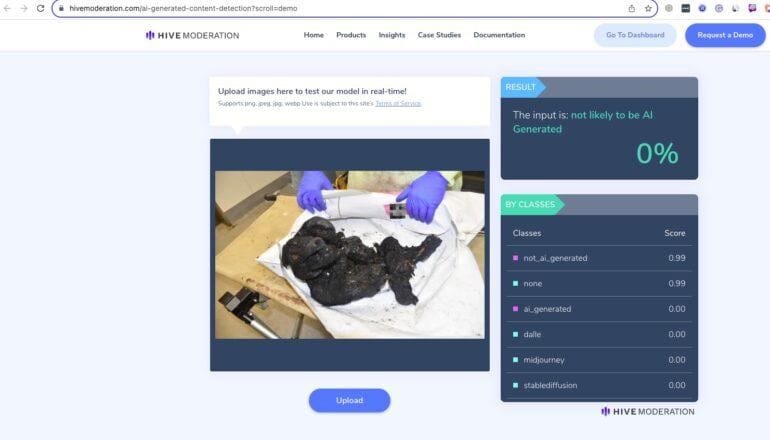

4. Другие инструменты

Урок четвертый. Используйте разные инструменты

Давайте посмотрим, что говорят про исходное изображение другие сервисы для определения AI-фейков, бесплатные и платные.

Сразу заметим, что ни один из подобных инструментов не идеален, и не стоит доверять им на 100%.

Мы отобрали те из них, которые смогли опознать вмешательство AI в сложных кейсах вроде обработанного фото Илона Маска из примера выше, то есть в случаях, когда оригинальное изображение было лишь слегка изменено при помощи AI. И хотя, как уже было сказано, доверять подобным инструментам на 100% нельзя, результаты проверки оказались вполне однозначны.

4.1 Maybe’s AI detector

4.2 ContentAtScale AI detector

4.3 Hive moderation

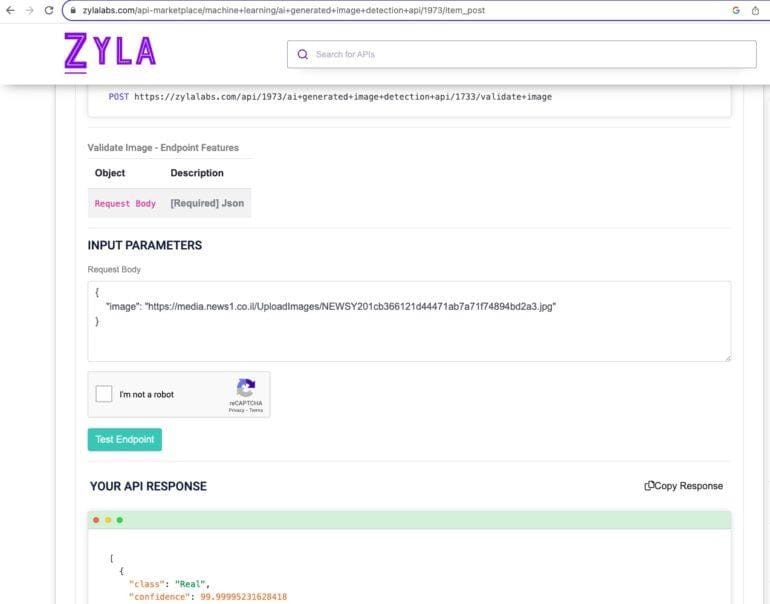

4.4. ZylaLabs AI detector

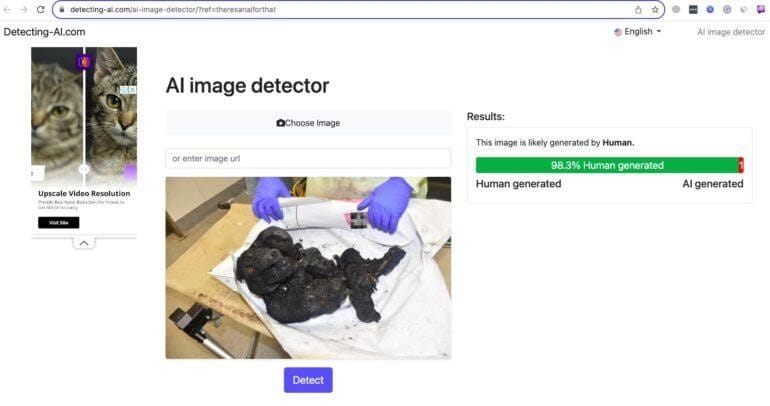

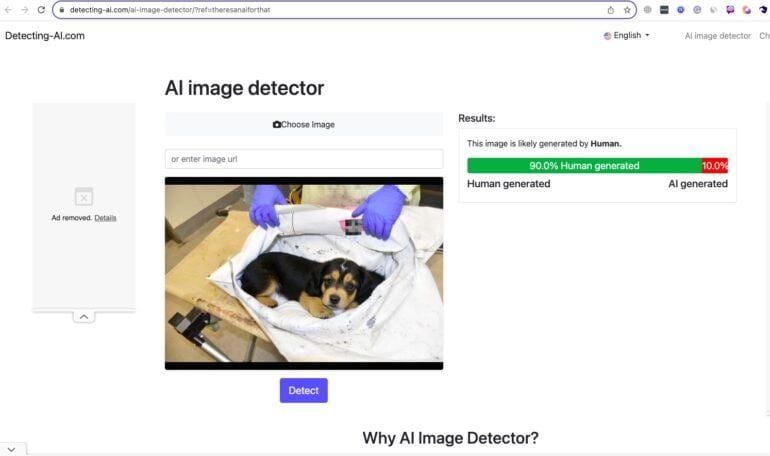

4.5. Detecting-AI AI detector

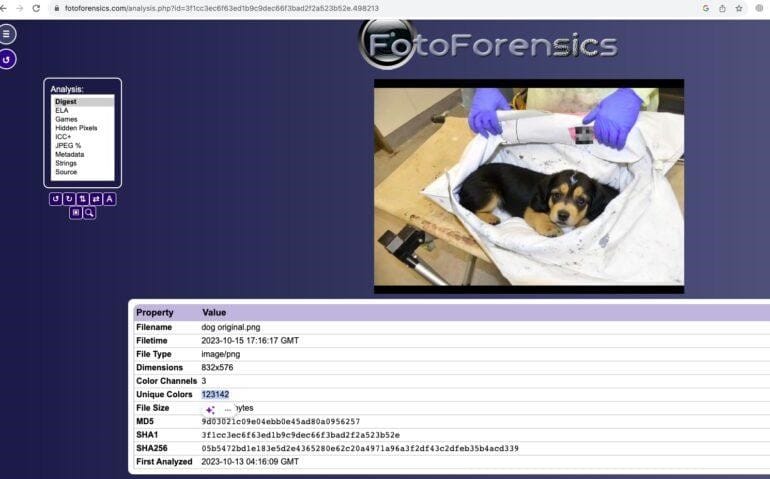

5. Фото с щенком

Урок пятый. Будьте настороже, обращайте внимание на подозрительные детали

Сверху и снизу изображения щенка, которое распространяется в соцсетях, мы видим черные поля. Обычно ничего подобного у оригинальных фотографий не бывает!😉

6. Происхождение фото с щенком

Урок шестой. Разберитесь в последовательности событий

Это — самая важная часть нашего расследования. Now let’s move to the most important part of the investigation. This is the most bizarre image of a dog that actually became viral.

не понимаю, почему тут "другой" и почему здесь ссылка на Ахмада — значит ли это, что блогер из начала текста взял кадр отсюда? или что?

Кажется, это очередной косяк оригинала (другие я сглаживал или убирал, благо они сути не касались, а тут это важная связка, поэтому так просто не обойдёшь. ВОЗМОЖНО, изначально имелось ввиду, что Хинкель взял фото из твита Ахмада, но это я вынужден додумывать, в оригинале этого нет, и фраза провисает

Выяснилось, что источник картинки со щенком — твит @stellarman22, в котором он прямым текстом сообщает, что это фейк, созданный “за пять минут”.

К сожалению, этот фейк широко разошёлся по сетям и был опубликован, в том числе в официальном аккаунте Альджазиры.

7. Глубокий анализ изображения

Урок седьмой. Пускайтесь во все тяжкие

У нас в арсенале есть и более продвинутые инструменты, которые помогут определить, какое изображение было исходным.

Давайте посмотрим, сколько уникальных цветов и оттенков имеется в наших двух изображениях.

У фото со щенком в два раза больше уникальных цветов, что косвенно подтверждает, что это — производное, а не исходное изображение. Не самое надёжное доказательство, но ещё один аргумент, о котором стоит помнить.

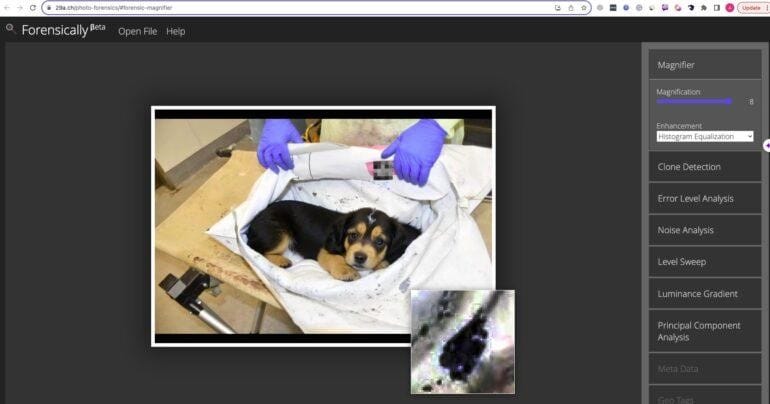

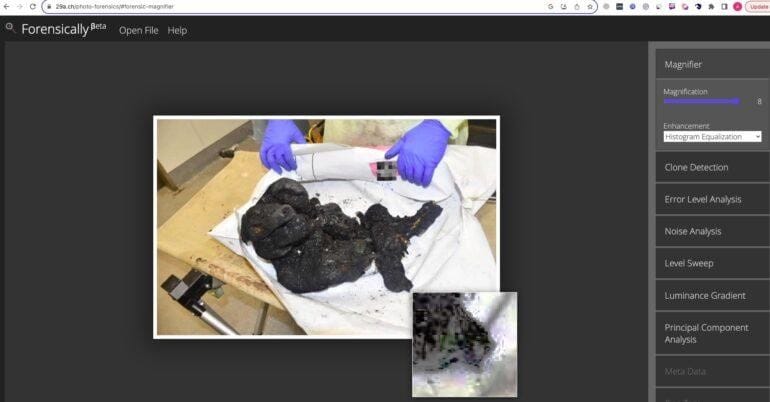

Давайте приглядимся к пятну в правом нижнем углу — если его приблизить, то оно не слишком похоже на реалистичное пятно грязи, скорее — на артефакт, оставшийся после обработки изображения.

На втором изображении на том же месте — фрагмент обгоревшего тела.

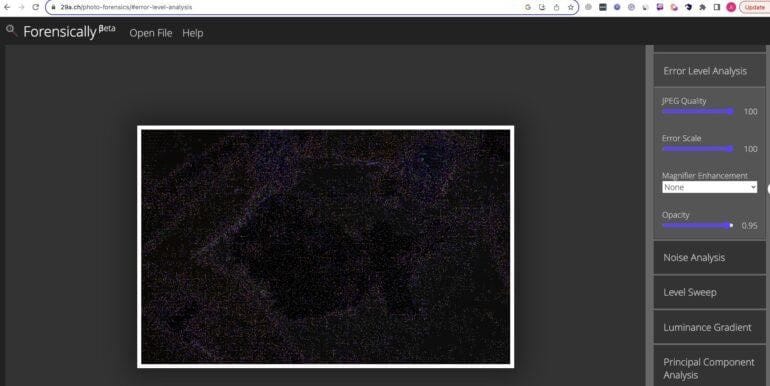

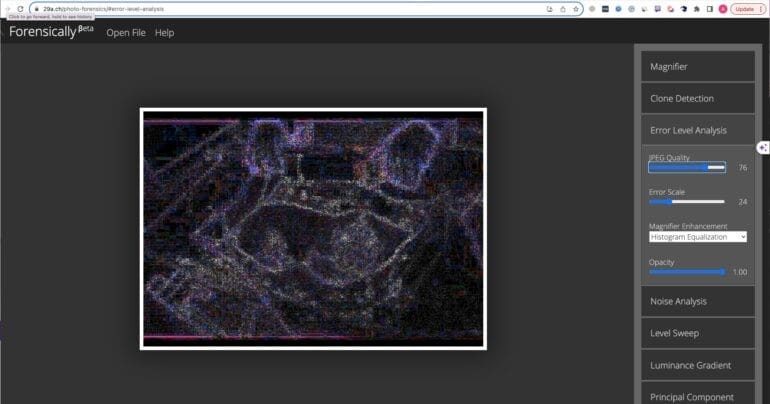

Газета The Arlington Post проанализировала оба изображения при помощи Error Level Analysis (анализа степеней ошибочности, ELA) — метода определения подделок путем изучения артефактов сжатия изображения. Артефакты сжатия, уровни резкости краёв изображения, шумы и уровни яркости изображения сгоревшего ребёнка — единообразны, что свидетельствует о том, что она не подвергалась редактированию.

С другой стороны, на фотографии со щенком артефакты сжатия инконсистентны, и то же относится к резкости краёв изображения, неравномерной яркости и неравномерности визуального шума на фотографии, что является прямым докозательством, что фотография подверглась модификации. К сожалению, оригинальный пост был удалён Титтером, так что мы решили повторить этот анализ. Оригинальное изображение показывает равномерные результаты при ELA-анализе.

На картинке же со щенком, число артефактов вокруг, собственно, щенка гораздо выше.

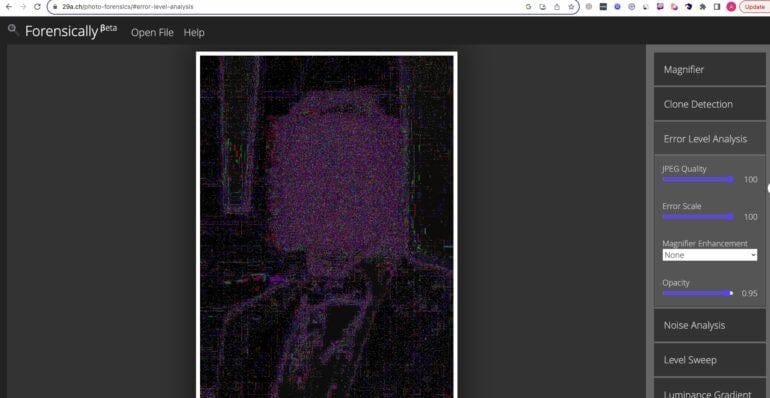

Чтобы разобраться, как работает этот метод анализа, мы решили проанализировать таким образом обработанное фото Илона Маска. Как видите, артефакты сжатия гораздо сильнее вокруг лица Маска и образуют квадрат.

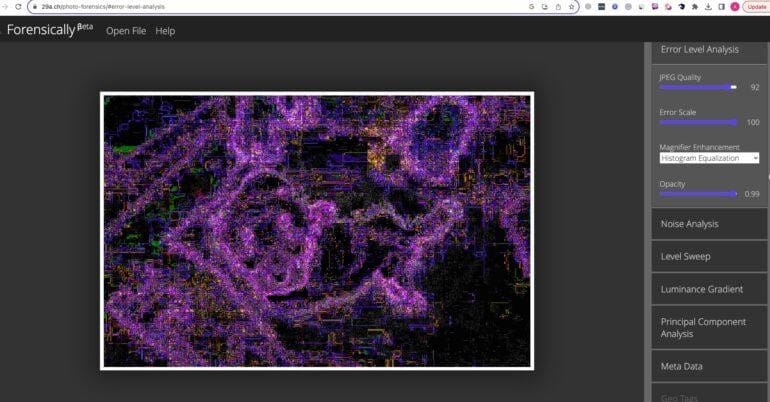

Этот квадрат — ровно та часть изображения, котору мы подвергли AI-манипуляциям. Давайте теперь попробуем воспроизвести фейк с щенком и посмотрим, как он будет выглядеть при ETA-анализе. Для этого мы используем AI-инструментарий, встроенный в Photoshop.

Как видите, и в этом случае плотность артефактов вокруг сгенерированной части изображения — выше.

Выводы

Надеемся, что эта статья не только убедительно доказала, что новости о "поддельных" фотографиях не соответствуют действительности, а сотрудники Альдазиры либо сознательно обманывают своих читателей, либо не обладают минимально необходимыми навыками факт чека, но и, что более важно, поможет в следующий раз вам самим провести факт-чек, прежде чем делиться непроверенными сведениями.

Напишите нам fakeornot@adversa.ai, если вы столкнетесь с другими примерами дезинформации с использованием потенциально сгенерированного искусственным интеллектом контента, связанного с вторжением ХАМАС, и мы постараемся помочь вам разобраться. Если вы хотите как-то поддержать нашу инициативу по борьбе с дезинформацией или сделать пожертвование, пожалуйста, свяжитесь с нами по адресу info@adversa.ai.

Заключение

Дезинформация, особенно когда она касается настолько чувствительных тем, усиливает недоверие, подпитывает конфликты и причиняет боль, которой и так уже слишком много.

Но не стоит отчаиваться. Борьба с обманом в цифровую эпоху вовсе не безнадёжна, и вовсе не обречена на провал. Просто для того, чтобы отделить факты от лжи, требуется упорство, самоотверженность и глубокое понимание технологий.

Мы хотим призвать разработчиков, исследователей и законотворцев объединиться для создания надёжных систем верификации фактов, разработки этических стандартов для AI и обучения людей методам, которые позволяют отличить правду ото лжи.

А СМИ, социальные платформы и блогеры должны помнить: любой контент, который мы распространяем, нуждается в строгой и всесторонней предварительной проверке. Ошибочная и ложная информация влияет на жизни реальных людей, это влияние огромно и относиться к этому легкомысленно — большая безответственность.